'구글 AI 포럼'은 최근 도래하고 있는 AI-First 시대를 맞아 인공지능 및 머신러닝과 관련해 좀 더 알기 쉬운 설명 및 사례와 함께 더욱 깊게 공부할 수 있는 기회를 제공하기 위해 구글이 준비한 행사로, 매월 진행되고 있다.

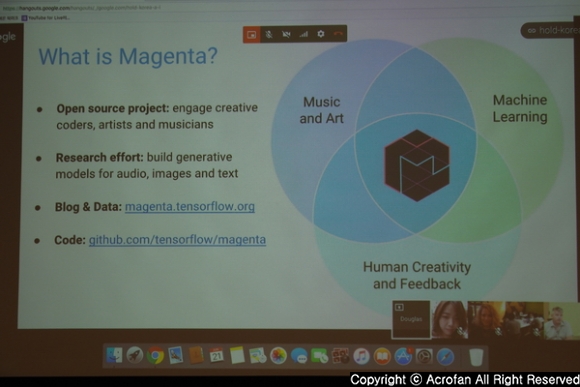

이날 행사에서는 구글 브레인 팀의 더글라스 에크 리서치 사이언티스트가 화상 강연을 통해 구글 브레인 팀이 진행 중인 마젠타 프로젝트에 대해 소개하는 시간을 가졌다.

|

▲ 구글 AI포럼 제5강 : AI 혁신, 그리고 아트&뮤직 행사가 개최됐다.

|

▲ 더글라스 에크 리서치 사이언티스트가 마젠타 프로젝트에 대해 소개했다.

마젠타 프로젝트는 '머신러닝을 통해 음악 또는 예술 작품을 만들고자 하는 호기심'에서 시작된 프로젝트로, 머신러닝을 창작의 영역으로 확대해 보려는 노력을 진행하고 있다. 이 마젠타 프로젝트는 단지 새로운 예술작품을 만드는 것에 그치지 않고, 예술 및 음악 창작법을 학습하는 알고리즘을 설계해 인간이 어떤 부분에서 감동과 흥미를 느끼는지 이해하고 창작에 활용하는 일련의 과정을 연구하고 있다.

에크 사이언티스트는 "레스 폴이 전자 기타를 개발하면서 많은 뮤지션들로 하여금 영감을 작품으로 이끌어냈던 것처럼 마젠트 프로젝트가 아티스트들이 다양한 것을 시도할 수 있는 도구와 같은 것을 만들고자 하는 노력을 이어가고 있는 중이다."라고 소개했다.

그 첫 번째 노력으로는 딥러닝 혹은 강화학습을 사용해 모델을 학습시켜 머신러닝에게 그림을 가르치는 연구가 진행 중이다. 이 모델은 픽셀이나 이미지에 기반을 두고 신경망이 여러 층으로 쌓여있는 상황에서 아래층의 신경망에서는 단순한 선이나 색상을 인식하고 학습하지만, 단계를 거치면서 그 범위를 넓혀, 궁극적으로 수만 개의 이미지를 인식할 수 있도록 한다.

이에 구글의 데이비드 하 박사는 일상 사물을 스케치하는 생성 네트워크 순환신경망(RNN)을 선보였는데, 이 순환신경망의 목표는 기계가 인간과 유사한 방식으로 추상적 개념을 그려내고 일반화할 수 있도록 학습시키는 것이다. 연구에서는 손으로 그린 스케치 데이터세트를 학습시켰으며, 각 스케치는 펜을 어느 방향으로 움직이고 언제 들어 올리고 언제 그리기를 멈추는지 등 펜을 컨트롤하는 운동 동작에 따라 정보가 생성되었다.

에크 사이언티스트는 사람들이 많이 그리는 사례 중 하나인 비를 예로 들었다. 그는 "빗방울을 하나 그렸을 경우 여러 개의 빗방울을 그려 비가 내리는 모습을 구현하는 것은 물론, 구름을 그렸을 경우 그 이후 구름에서 비가 내리는 모습을 그리는 것을 네트워크 순환신경망이 학습했다. 반대로 비를 먼저 그렸을 경우 이후 구름을 그리는 경우는 그리 많지 않다는 점 역시 사람들의 그림 패턴에 따라 자연스럽게 익히게 되었다."고 소개했다.

이 외에도 인코더와 디코더 간의 커뮤니케이션 채널에 노이즈를 추가, 잠재 벡터로 스케치의 주요 특징을 포착하는 방법을 학습, 새로운 스케치를 구성하는데 필요한 일련의 운동 동작을 구성, 스스로 재구성된 스케치를 생성했다. 이렇게 재구성된 스케치는 입력 스케치의 복사본이 아니라, 유사한 특징을 가진 이미지를 스스로 새로 스케치함으로써 스스로 학습하고 있음을 증명해 보였다.

현재 구글은 이 개념을 확장해 여러 모델에서 동일한 미완성 스케치를 완성하는 단계까지 성공했다. 이에 다양한 사물을 그리도록 학습된 여러 모델을 사용하면 유의미한 시각적 메시지로 소통할 수 있는 창의적인 방법을 개발할 수 있을 것으로 전망했다.

|

▲ 마젠타 프로젝트는 머신러닝을 통해 음악 또는 예술 작품을 만들고자 하는 프로젝트다.

|

▲ 모델을 학습시켜 머신러닝에게 그림을 가르치는 연구가 진행 중이다.

|

▲ 유사한 특징을 가진 이미지를 스스로 새로 스케치해 보여준다.

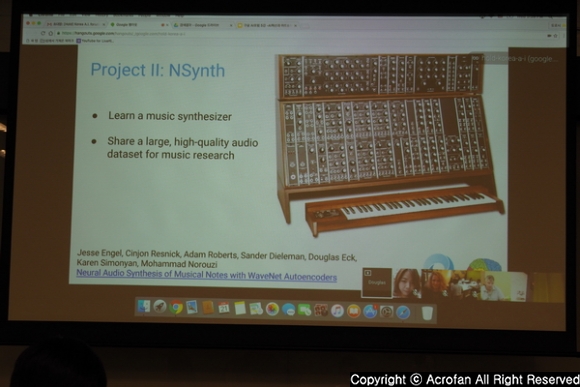

이어 마젠타 프로젝트가 진행 중인 두 번째 노력으로 신경 오디오 합성 방식인 NSynch(Neutral Synthesizer, 신경 신디사이저)가 소개됐다. 구글 브레인 팀은 영국의 딥마인드와의 협업을 통해 새로운 소리를 만들어 내기 위해 NSynch의 연구를 진행 중이며, '새로운 악기 사운드를 만들어 낸다.'는 궁극적 목표에 다가가고 있는 중이다.

여기에서 사용되는 것이 음성, 음악과 같은 시간적 시퀀스를 위한 표현 모델인 웨이브넷이다. 웨이브넷은 확장성 콘볼루션의 심층 자기회귀 네트워크로, 비선형적 무한 임펄스 응답 필터와 유사하게 한 번에 하나의 사운드 샘플을 모델링한다.

한편 마젠타 프로젝트의 목표로 예술적 창의성과 머신러닝의 간극을 좁히는 것인 만큼, 값을 안정화 할 수 있는 시간적 임베딩 학습을 적용해 악기의 음과 음사이의 공간을 탐색할 수 있도록 했으며, 그 결과 신경 신디사이저를 통해 완벽하게 악기의 원음을 재현할 수 없지만 두 개의 악기를 합성했을 때 새로운 음색을 만들 수 있게 됐다.

이에 구글은 마젠타 프로젝트의 홈페이지는 다양한 악기를 합성해 볼 수 있도록 데모를 제공하고 있으며, 이 기술을 활용하여 나만의 음악을 만들 수 있는 연주 가능한 악기도 공개했다.

에크 사이언티스트는 "마젠타 프로젝트는 아직 많은 부분이 남아있지만, 이후 진행될 심층적인 학습을 통해 아티스트의 능력을 확장할 수 있는 기회가 있다고 생각한다."며 "현재 예술에서 다른 아티스트 및 그들의 유산으로부터 배우고 학습시키고 있는 만큼 꾸준히 발전을 이어갈 것으로 생각한다."라고 밝혔다.

|

▲ 새로운 악기 사운드를 만들어 내기 위해 NSynch의 연구를 진행 중이다.

|

▲ 웨이브넷은 음성, 음악과 같은 시간적 시퀀스를 위한 표현 모델이다.

|

▲ 악기의 음과 음사이의 공간을 탐색할 수 있도록 했다.

Copyright ⓒ Acrofan All Right Reserved.

마이크로소프트, 이그나이트 2023에서 AI 미래 여는 혁신 ..

마이크로소프트, 이그나이트 2023에서 AI 미래 여는 혁신 .. 네이버 두 번째 IDC '각 세종', "초대규모 AI , 클라우드 등..

네이버 두 번째 IDC '각 세종', "초대규모 AI , 클라우드 등..

로터스의 하이퍼 SUV 엘레트라, 국내 판매 가..

로터스의 하이퍼 SUV 엘레트라, 국내 판매 가.. 머스탱 60주년 역사와 함께한 포드의 발자..

머스탱 60주년 역사와 함께한 포드의 발자..